Aarón Moreno Inglés

Universidad Técnica de Delft . Miembro de Niaiá

¿Hasta dónde llega la ética de la tecnología?

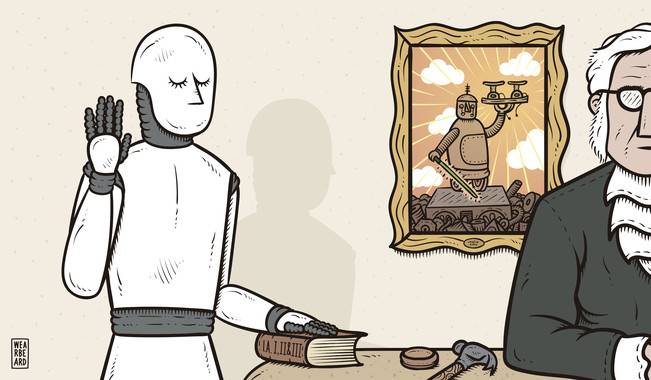

Los riesgos socio-técnicos causados por el uso de la inteligencia artificial son cada vez más preocupantes. El problema de los deepfakes y otras repercusiones de la IA generativa (García Haendler, 2024), los sesgos racistas y machistas en la clasificación de los datos (Noble, 2018; Gebru, 2020; Akter 2021), las reiteradas violaciones de privacidad y recopilación de datos de forma indebida (Bartneck et al., 2021), la vigilancia masiva con motivos políticos y comerciales (Feldstein, 2019) son parte del impacto dañino de la inteligencia artificial. Por eso, no es de extrañar que diversas instituciones busquen diseñar y adoptar estándares éticos para guiarse a la hora de usar IA o salvaguardarse de sus efectos.

En muchos casos, estos estándares ofrecen valores ético-políticos que seguir de forma deontológica, à la Kant. Los valores pueden partir de conceptos muy amplios (justicia, seguridad, igualdad) o más concretos, relacionados con los sistemas y artefactos en particular que se pretenden estudiar (explicabilidad, contestabilidad, transparencia). Escoger e interpretar estos valores supone necesariamente integrar una visión del mundo específica en el diseño y la producción tecnológica. Tal y como Langdon Winner exponía en 1980, los artefactos tienen política, independientemente de si somos conscientes o no de ello. Los distintos códigos deontológicos que construyamos deberán tener esto en cuenta y, en la medida de lo posible, explicitar cómo se concretan dichos valores en torno a los sistemas particulares de inteligencia artificial.

Esta ponencia pretende estudiar el contenido, el resultado, y las limitaciones de distintos códigos deontológicos propuestos para el desarrollo de sistemas de inteligencia artificial y, a su vez, problematizar lo insuficiente de algunas perspectivas éticas para enfrentar de forma eficaz estos riesgos.

Se presenta, a su vez, una aproximación interdisciplinar a los códigos morales y protocolos de actuación, que beba de la economía política y tenga en cuenta la materialidad de la inteligencia artificial, superando las lógicas neoliberales, extractivistas y neocoloniales en las que se enmarca. Esto implica estudiar el diseño y el proceso de producción de la IA al completo, pasando por la extracción de minerales, la compleja logística de cables submarinos, la fabricación de microchips, la moderación de contenido, la gestión de los datos, y el elevado coste energético de las giga-fábricas y procesadores, entre otras cuestiones.

Como material opcional, se propone la lectura del mapa/ensayo de Kate Crawford y Vladan Joler (2018): “Anatomía de un sistema de IA: Amazon Echo como mapa anatómico del trabajo humano, los datos y los recursos planetarios.” Se encuentra fácilmente accesible y traducible en: https://anatomyof.ai/

El seminario se celebró en línea el 22/05/2024

Puedes escuchar la grabación en audio (71,2 MB) en este enlace. Si deseas acceder a una grabación en vídeo (257,4 MB), puedes obtenerlo en este enlace.

Para citar esta entrada

Aarón Moreno Inglés. Universidad Técnica de Delft. En Niaiá, consultado el 15/05/2024 En https://niaia.es/codigos-eticos-empresariales-de-la-teoria-a-la-realidad/

Creemos en el libre flujo de información. Republique nuestros artículos libremente, en impreso o digital, bajo licencia Creative Commons, citando la fuente

La Web de NIAIÁ y sus publicaciones (salvo aquellas en las que se especifique de otra manera) están bajo una Licencia Creative Commons Atribución-NoComercial-SinDerivadas 4.0 Internacional