Borja García Händel

Responsable de Riesgo de Mercado y Tesorería para Asia en Julius Baer desde Singapur, donde lidera iniciativas de innovación y es formador desde 2019 en Inteligencia Artificial y ciencia de datos.

Si la idea de que una máquina pueda pensar y razonar como un ser humano le suena a ciencia ficción, no está solo. La Inteligencia Artificial (IA), esta idea de la que todo el mundo está hablando últimamente, y con razón, es una tecnología que despierta tanta fascinación como desconfianza. Sin embargo, al evaluar los argumentos o las respuestas generadas por una IA, es importante evitar caer en la falacia ad hominem, específicamente en lo que podríamos denominar «falacia ad intelligentiam artificialem». Este error lógico no solo limita nuestra capacidad para comprender el verdadero potencial de la IA, sino que también nos aleja de una evaluación justa y racional de sus contribuciones. Y estamos ante una revolución que va a marcar un antes y un después sin lugar a dudas.

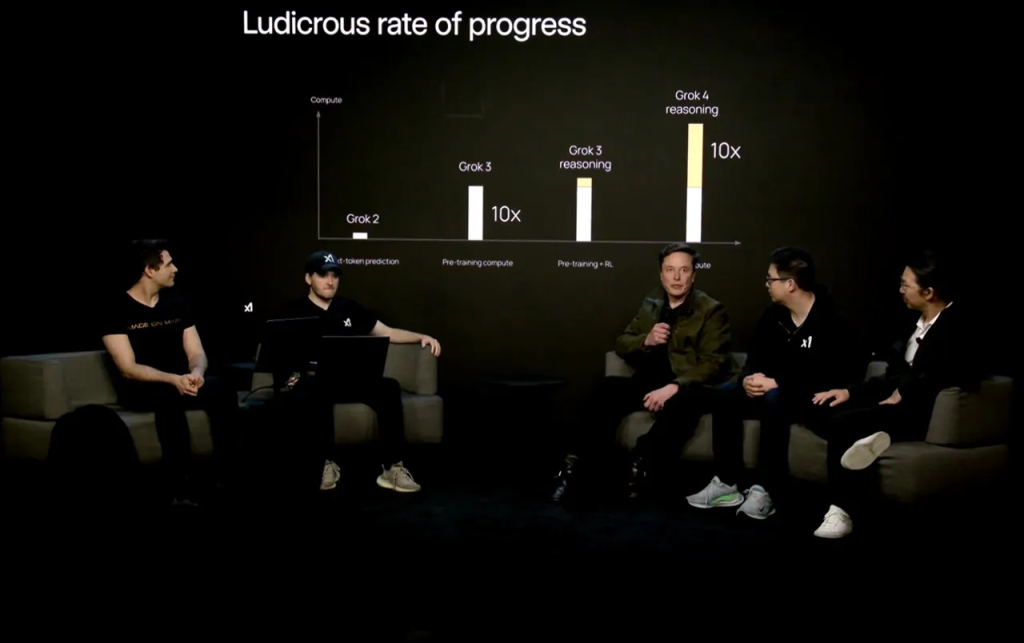

Lo que pretendo en este artículo, es explorar esta falacia, su aplicación a la IA, unos ejemplos históricos de rechazo a nuevas tecnologías y las limitaciones de la IA en comparación con las humanas. Todo esto cuando se acaba de anunciar el último modelo de Grok, una de tantas AIs, que anticipa unos cambios sustanciales en la ciencia, y el entendimiento humano gracias a esta tecnología. El objetivo final es que los argumentos de la IA merecen ser evaluados por su mérito y no por su origen.

La inteligencia artificial avanza a un ritmo vertiginoso, con nuevos modelos que superan constantemente los límites de lo posible. A la par de la fascinación, sin embargo, crece la desconfianza. Para evaluar de manera justa las contribuciones de la IA, es fundamental evitar la «falacia ad intelligentiam artificialem», un error lógico que nos aleja de una valoración racional de sus argumentos.

En el panorama actual de la IA, los benchmarks son herramientas esenciales para medir el rendimiento de los modelos en tareas que van desde el razonamiento lógico hasta la generación de código. En 2025, modelos como Grok-4 de xAI, GPT-4o de OpenAI, Claude Opus de Anthropic y Gemini 2.5 Pro de Google, entre otros, han marcado nuevos hitos en diversas pruebas de referencia.

Imagen obtenida de: https://aibusiness.com/generative-ai/elon-musk-xai-unveils-grok-4-calls-it-world-s-smartest-ai-

«Grok 4 is smarter than almost all graduate students in all disciplines simultaneously […]With respect to academic questions Grok 4 is better than PhD level in every subject no exceptions.[…] There are no humans that can actually answer these can get a good score. […] We’re at the beginning of an immense intelligence explosion. We’re in the intelligence big bang right now and we’re at the most interesting time to be alive of any time in history.»

Elon Musk durante la presentación de Grok 4, 9 de Julio de 2025

Grok-4 ha demostrado capacidades sobresalientes en algunos de los benchmarks más exigentes:

- Humanity’s Last Exam (HLE): Diseñado para evaluar el razonamiento avanzado y el conocimiento multidisciplinario, Grok-4 ha obtenido puntuaciones de entre el 35 % y el 45 %, una cifra notablemente superior al 21 % promedio de otros modelos líderes.

- American Invitational Mathematics Examination (AIME): En esta prestigiosa competencia matemática, Grok-4 alcanzó una puntuación de 95 en la versión de 2025, lo que evidencia su excepcional habilidad para resolver problemas complejos.

- General Professional Questions Assessment (GPQA): Este benchmark, que mide el razonamiento en disciplinas científicas, vio a Grok-4 obtener una puntuación de 88, destacando su aptitud para manejar interrogantes científicos de alta complejidad.

- SWE-bench: Al evaluar la capacidad para resolver problemas de ingeniería de software del mundo real, Grok-4 logró una puntuación de 75, lo que demuestra su potencial como asistente en tareas de programación.

Si bien estos resultados son impresionantes, es importante considerar el contexto. GPT-4o, por ejemplo, es muy versátil en el manejo del lenguaje natural, mientras que Claude Opus brilla en la generación de texto creativo. Gemini 2.5 Pro, por su parte, es eficiente en tareas multimodales. Grok-4 sobresale en el razonamiento profundo, aunque puede ser menos eficiente en tareas que requieren contextos extremadamente amplios.

La falacia ad hominem, del latín «contra el hombre», es un error lógico en el que, en lugar de refutar los argumentos de alguien, se ataca a la persona que los emite. Por ejemplo, en un debate político, alguien podría decir: «No confío en las propuestas de ese candidato porque es de tal partido». Aquí, en lugar de analizar las propuestas, se descalifica al candidato por su vida personal, su religión, su ideología, etc. Este tipo de falacia es común porque apela a las emociones en lugar de la lógica, desviando la atención del argumento en sí hacia la fuente que lo presenta. Según la definición de Wikipedia, la falacia ad hominem se utiliza como una técnica retórica efectiva para persuadir a personas que se guían más por sentimientos que por la lógica.

En el contexto de la IA, la falacia ad hominem se manifiesta cuando se descarta un argumento simplemente porque proviene de una máquina, sin considerar su validez o la evidencia que lo respalda. Por ejemplo, si una IA propone una estrategia para reducir emisiones basada en datos climáticos, decir «eso no vale porque lo dijo una máquina» es un error lógico. La validez de un argumento no depende de quién lo emite, sino de su lógica, evidencia y coherencia.

La «falacia ad intelligentiam artificialem» ocurre cuando se desestima un argumento o una solución generada por una IA solo porque su origen es una máquina, sin evaluar su contenido. Esto es problemático porque, al igual que con los humanos, los argumentos de una IA deben ser juzgados por su mérito. Por ejemplo, si una IA analiza datos médicos y sugiere un diagnóstico, no deberíamos ignorarlo solo porque «las máquinas no entienden de medicina», sino revisar los datos y el razonamiento detrás de la sugerencia. Descalificar a la IA por su naturaleza es tan irracional como descalificar a una persona por su origen, género o educación.

Esta falacia es especialmente relevante hoy, cuando la IA está transformando sectores como la medicina, la logística y la educación. Según un estudio de 2023, el uso de la IA en empresas españolas creció un 3,5% respecto a 2022, alcanzando un 11,8% de adopción (IA, ventajas y desventajas). Sin embargo, la desconfianza hacia la IA persiste, a menudo alimentada por el miedo a lo desconocido, desconfianza por perder el trabajo o por malentendidos sobre sus capacidades.

La historia nos ofrece numerosos ejemplos de cómo las nuevas tecnologías fueron inicialmente recibidas con escepticismo o rechazo, un patrón que se repite con la IA. A continuación, presentamos tres casos emblemáticos:

| Tecnología | Año | Rechazo inicial | Impacto final |

| Imprenta | 1450 | Temida por difundir ideas «peligrosas» y socavar la autoridad de la Iglesia. | Democratizó el conocimiento, impulsó la educación y la Reforma Protestante. |

| Teléfono | 1876 | Western Union lo descartó como un medio de comunicación con «demasiados defectos». | Revolucionó la comunicación global, convirtiéndose en una herramienta esencial. |

| Computadora personal | 1977 | Ken Olsen afirmó que nadie querría una en casa. | Transformó el trabajo, la educación y el entretenimiento en todo el mundo. |

- La imprenta: En el siglo XV, la invención de Johannes Gutenberg fue vista con recelo por las autoridades religiosas, que temían que el acceso masivo a libros fomentaría ideas heréticas. Sin embargo, la imprenta permitió la difusión del conocimiento, allanando el camino para la Reforma Protestante y la Ilustración.

- El teléfono: En 1876, Western Union, líder en telégrafos, desestimó el teléfono de Alexander Graham Bell, afirmando que «no tenía valor alguno». Hoy, el teléfono es una herramienta indispensable que ha transformado la comunicación global.

- La computadora personal: En 1977, Ken Olsen, fundador de Digital Equipment Corporation, afirmó: «No hay razón para que alguien quiera una computadora en su hogar». Esta visión miope subestimó el impacto de las computadoras personales, que hoy son esenciales en casi todos los aspectos de la vida moderna.

Estos ejemplos ilustran que el escepticismo hacia las nuevas tecnologías es un fenómeno recurrente. La IA, como tecnología disruptiva, enfrenta una desconfianza similar. Sin embargo, descartar sus argumentos por su origen es repetir los errores del pasado, ignorando su potencial para resolver problemas complejos.

Es innegable que la IA tiene limitaciones. Aunque es capaz de procesar grandes cantidades de datos y realizar tareas específicas con gran precisión, carece de ciertas habilidades humanas. Algunas de las limitaciones más destacadas incluyen:

- Sesgos algorítmicos: Si los datos con los que se entrena una IA contienen prejuicios, como desigualdades sociales, la IA puede perpetuar esos sesgos, resultando en decisiones injustas. Por ejemplo, un sistema de contratación basado en IA podría favorecer a ciertos grupos si los datos históricos reflejan desigualdades.

- Falta de contexto: La IA puede tener dificultades para entender las sutilezas del lenguaje humano o el contexto cultural, lo que limita su capacidad para manejar situaciones complejas. Por ejemplo, una IA podría malinterpretar un chiste o una metáfora.

- Ausencia de empatía y juicio ético: La IA no tiene emociones ni un marco ético innato. Sus decisiones dependen de cómo fue entrenada, lo que puede llevar a errores en situaciones que requieren sensibilidad moral.

Estas limitaciones no son razones para descartar los argumentos de la IA, sino oportunidades para mejorar la tecnología. Por ejemplo, los sesgos algorítmicos pueden mitigarse utilizando datos más diversos y transparentes, mientras que la falta de contexto puede abordarse con modelos más avanzados que integren conocimiento cultural. La IA es una herramienta en evolución, y sus defectos son áreas de crecimiento, no excusas para rechazarla. Como señala Infobae, a pesar de sus limitaciones, la IA sigue avanzando, ofreciendo soluciones como diagnósticos médicos más precisos y conducción autónoma más segura.

Los humanos también tenemos limitaciones en su razonamiento, nadie es inmune a los errores. Expongo algunos ejemplos comunes incluyen:

- Sesgo de confirmación: Tendemos a buscar información que confirme nuestras creencias preexistentes, ignorando evidencia contraria. Por ejemplo, alguien podría rechazar datos sobre el cambio climático porque contradicen su visión política.

- Efecto de anclaje: Damos demasiado peso a la primera información que recibimos, lo que puede sesgar nuestras decisiones. Por ejemplo, una oferta inicial en una negociación puede influir desproporcionadamente en el resultado final.

- Falacia de la apelación a la emoción: Usamos emociones para persuadir en lugar de argumentos lógicos, lo que puede llevar a decisiones irracionales. Por ejemplo, un discurso político puede apelar al miedo en lugar de presentar hechos.

Estas limitaciones humanas son análogas a las de la IA. Si no descartamos los argumentos de una persona por sus sesgos o emociones, tampoco deberíamos hacerlo con los de una IA. La clave está en evaluar cada argumento por su lógica y evidencia, independientemente de su origen. Tanto los humanos como la IA tienen defectos, pero ambos pueden ofrecer contribuciones valiosas si se les da una oportunidad justa.

En definitiva, al interactuar con la IA, debemos evitar la falacia ad intelligentiam artificialem y evaluar sus argumentos por su mérito. La historia nos enseña que las nuevas tecnologías, desde la imprenta hasta la computadora personal, han enfrentado escepticismo inicial, pero su impacto transformador se revela con el tiempo. Aunque la IA tiene limitaciones, como sesgos algorítmicos y falta de empatía, estas son áreas para el crecimiento y la mejora, no razones para descartar sus contribuciones. Los humanos, con nuestros propios sesgos y errores, no somos perfectos, pero no por eso se nos descalifica. Del mismo modo, los argumentos de la IA deben ser juzgados por su contenido, no por su origen. La próxima vez que una IA ofrezca una solución o un argumento, considere su lógica y evidencia antes de decidir. Al hacerlo, no solo evitaremos caer en la falacia ad intelligentiam artificialem, sino que también abriremos la puerta al enorme potencial de esta tecnología.

Referencias

- Argumento ad hominem – Wikipedia, la enciclopedia libre

- Falacia ad hominem | Ejemplos y significado

- ¿Cuáles serían ejemplos de falacia ad hominem?

- Argumento ad hominem | Falacias lógicas explicadas gráficamente

- Ad Hominem Fallacy – Excelsior OWL

- Qué es la falacia ad hominem y cómo utilizarla retóricamente | JC Durán

- Un argumento ‘ad hominem’ La falacia como ataque

- Falacia ad hominem (qué es, características y ejemplos)

- Falacia ad hominem, cuando se ataca sin argumentos

- Falacia ad hominem: concepto, características, ejemplos

- https://x.ai/news/grok-4

- xAl’s Mind Blowing Grok 4 Demo w/ Elon Musk (FULL REPLAY)

Para citar esta entrada

García Händel, Borja Falacia Ad Intelligentiam Artificialem: Cuando Atacamos a la IA en lugar del ArgumentoConsultar en Niaia 26/10/2025. Ha sido publicada previamente en The Conversation. 25/01/2025

Creemos en el libre flujo de información. Republique nuestros artículos libremente, en impreso o digital, bajo licencia Creative Commons, citando la fuente

La Web de NIAIÁ y sus publicaciones (salvo aquellas en las que se especifique de otra manera) están bajo una Licencia Creative Com